AlphaFold3 开源啦!!!

AlphaFold3正式开源,这一突破性的蛋白质预测工具将对生物学和科学研究产生深远影响。本文详细介绍了AlphaFold3的技术特点、应用场景及其对开发者社区的重大贡献,探讨了这一开源项目的未来潜力...

你不需要招一个天才Prompt少年,也不需要玄幻的prompt来做开发

本文探讨了在AI开发中并不需要寻找天才Prompt少年或使用玄幻的Prompt。通过实用技巧和案例分析,本文介绍了如何高效地利用现有的Prompt技术进行项目开发,为企业提供切实可行的建议和方法。

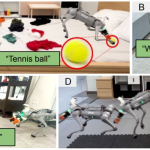

黄仁勋宣布机器人迎来“ChatGPT时刻”:告别5090,开启新时代

在最新演讲中,黄仁勋提出,机器人行业正迎来前所未有的变革,随着“ChatGPT时刻”的到来,我们将告别5090,开启机器人技术的新时代。

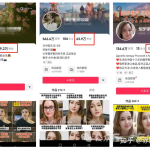

AI合成俄罗斯美女带货视频,抖音100天涨粉63.9万+,单号佣金赚10万+!

本文揭示了如何利用AI技术合成俄罗斯美女带货视频,在抖音平台上实现快速涨粉和高效变现的经验。文章将详细介绍AI视频合成的技术要点、内容创作策略、以及在抖音平台上进行推广和运营的有效方法...