今天,我们将发布 xAI Colossus 超级计算机之旅。对于那些听说过埃隆·马斯克的 xAI 在孟菲斯建造巨型 AI 超级计算机的人来说,这就是那个集群。这个价值数十亿美元的 AI 集群拥有 100,000 个 NVIDIA H100 GPU,不仅规模大,而且建造速度快。仅用 122 天,团队就建造了这个巨型集群。今天,我们将带您参观大楼内部。

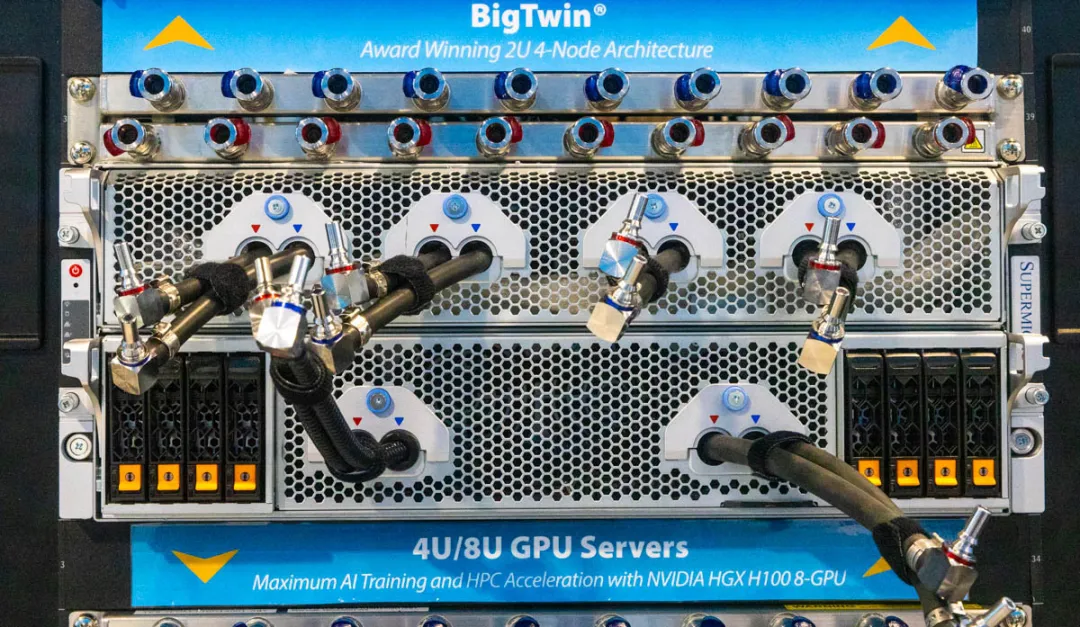

xAI 的超微液冷机架

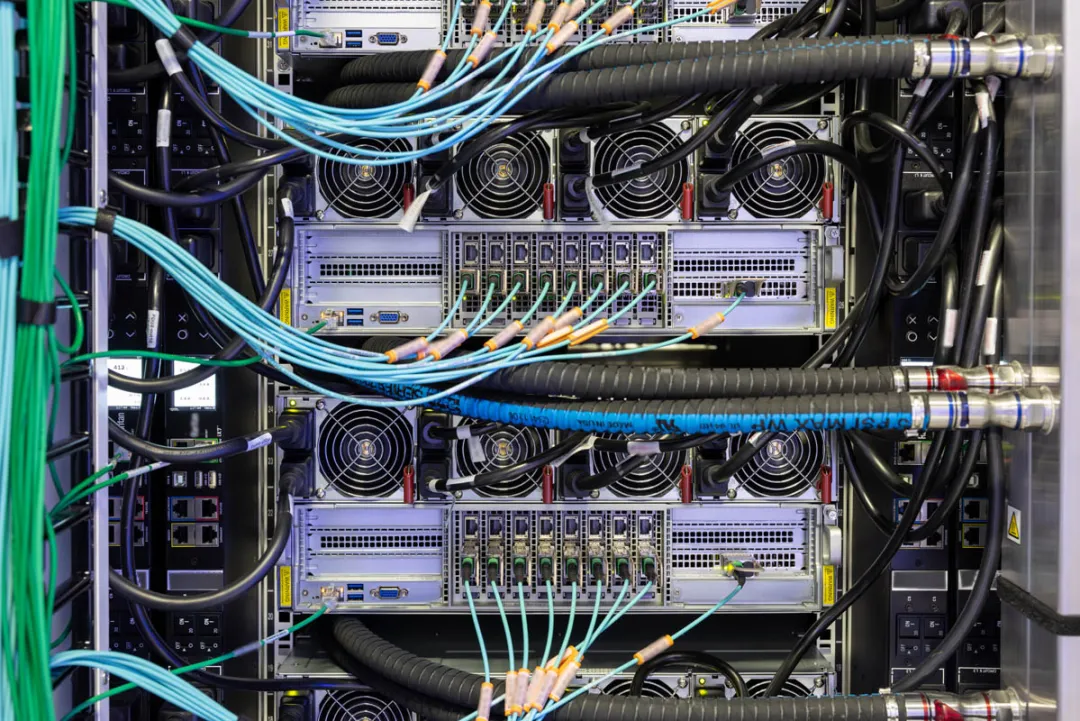

Colossus(巨人) 的基本构建模块是 Supermicro (超微)液冷机架。它由 8 台 4U 服务器组成,每台服务器配备 8 个 NVIDIA H100,每台机架总共有 64 个 GPU。8 台这样的 GPU 服务器加上一台Supermicro 冷却液分配单元 (CDU)和相关硬件构成了一个 GPU 计算机架。

XAI 巨人数据中心的超微液冷节点低角度视图

这些机架以八个为一组排列,共有 512 个 GPU,并通过网络连接形成迷你集群,融入到这个更大的系统中。

XAI 巨人数据中心的超微 4U 通用 GPU 液冷服务器

在这里,xAI 采用了超微的 4U 通用 GPU 系统。这些服务器是目前市场上最先进的人工智能服务器,主要有两个原因:一是其液冷技术的先进性,二是它们的易维护性。

XAI 巨人数据中心的超微 4U 通用 GPU 液冷服务器特写镜头

我们大约在一年前的超级计算大会 2023(SC23)上首次看到了这些系统的原型。在我们访问孟菲斯(Memphis)时,由于系统正在忙于训练任务,我们无法打开其中一台设备。一个例子是,这些系统放在可维护的托盘上,无需将其从机架中取出。1U 机架的分配器能够为每个系统引入冷液并排出热液。快速断开连接使得处理液冷系统变得更为迅速,我们去年展示了这些连接如何可以单手拆卸和安装。拆卸后,托盘可以方便地拉出来进行维护。

超微的 4U 通用 GPU 系统,专为液冷的 NVIDIA HGX H100 和 HGX 200 设计,在 SC23 上展示。

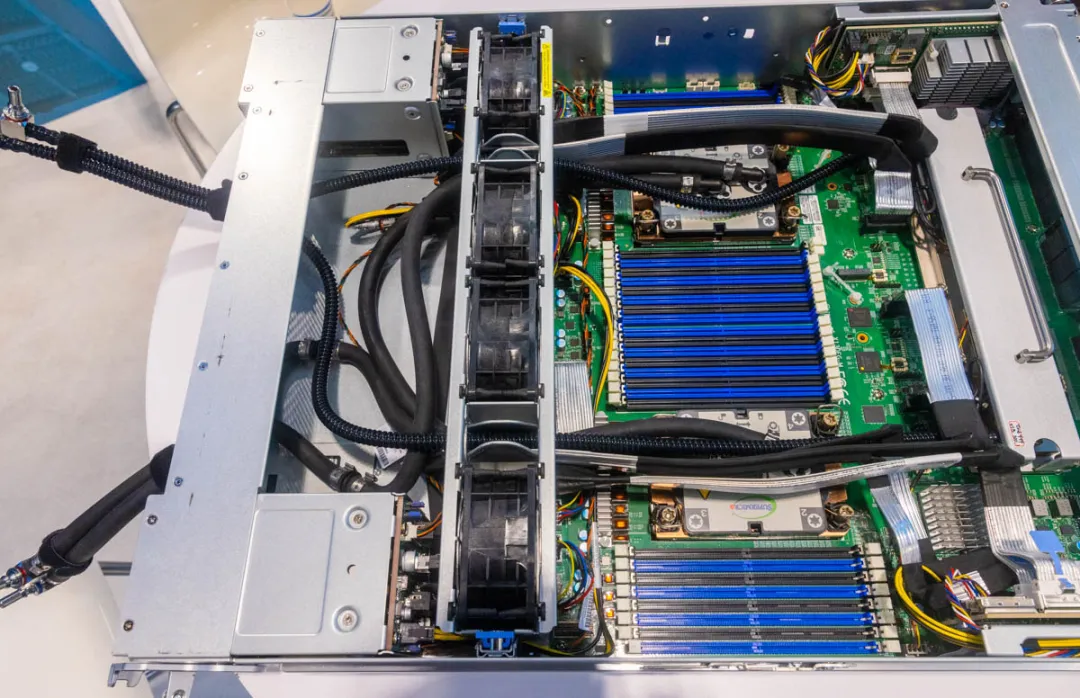

幸运的是,我们有这款服务器原型的图片,可以向大家展示这些系统内部的构造。除了配备定制超级微液冷模块的 8 GPU NVIDIA HGX 托盘外,CPU 托盘也显示了这些设计为何是行业内独一无二的下一代方案。

超微的 4U 通用 GPU 系统,专为液冷的 NVIDIA HGX H100 和 HGX 200 设计,在 SC23 上展出。

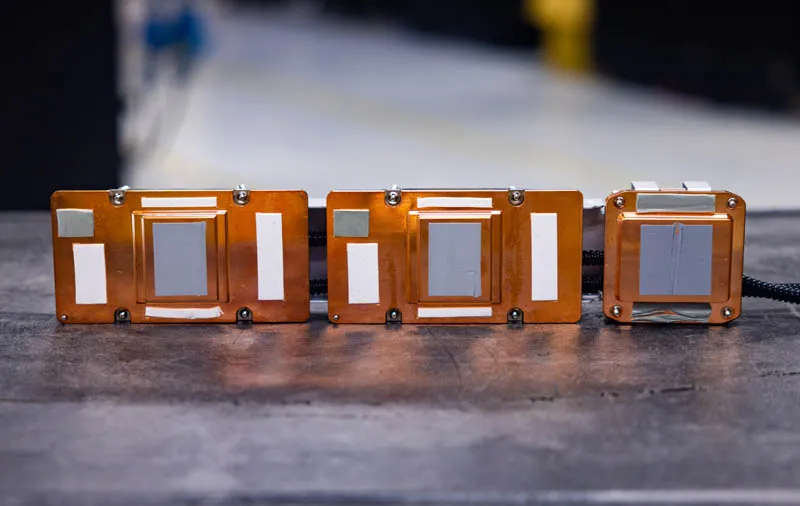

上面 SC23 原型中的两个 x86 CPU 液冷模块相对普遍。独特之处在于右侧。超微的主板将四个 Broadcom PCIe 交换机集成在一起,这在如今几乎所有 HGX 人工智能服务器中都能见到,而不是放在单独的电路板上。超微还为这四个 PCIe 交换机设计了一个定制的液冷模块。其他行业内的人工智能服务器通常是先搭建好,然后再加上液冷以补充空气冷却设计。而超微的设计则从一开始就是为了液冷而打造,并且所有组件均由同一家供应商提供。

超微 SYS 821GE TNHR NVIDIA H100 和 NVSwitch 液冷模块 8

这就像汽车,有些车型最初是为汽油动力设计的,后来才将电动动力系统适配到底盘上,而电动车则从一开始就专为电动动力设计。这个超微系统属于后者,而其他 HGX H100 系统则属于前者。自 HGX H100/H200 平台推出以来,我们对大多数公开的 HGX H100/H200 平台以及一些超大规模设计都有过亲身体验。可以毫不夸张地说,这个超微系统与其他系统之间的差距很大,包括我们之前评测的其他一些超微设计,它们可以采用液冷或风冷。

在机架的后面,我们可以看到用于 400GbE 连接的光纤,连接到 GPU 和 CPU 系统,还有用于管理网络的铜缆。这些网络接口卡(NIC)被放在独立的托盘上,方便热插拔,无需拆卸机箱,但它们的位置是在机箱的后面。每台服务器配有四个电源,同样支持热插拔,并通过三相 PDU 供电。

XAI Colossus 数据中心 Supermicro 4U 通用 GPU 液冷服务器后置 1

在机架底部是冷却液分配单元(CDU),它们像巨大的热交换器。在每个机架内,有一个流体回路为所有的 GPU 服务器供液。我们这里使用“流体”这个词而不是“水”,因为这些回路通常需要调配适合液冷组件的液体。如果您想更深入了解 CDU 和流体的工作原理,我们有相关文章和视频。

XAI Colossus 数据中心 Supermicro CDU 位于机架底部

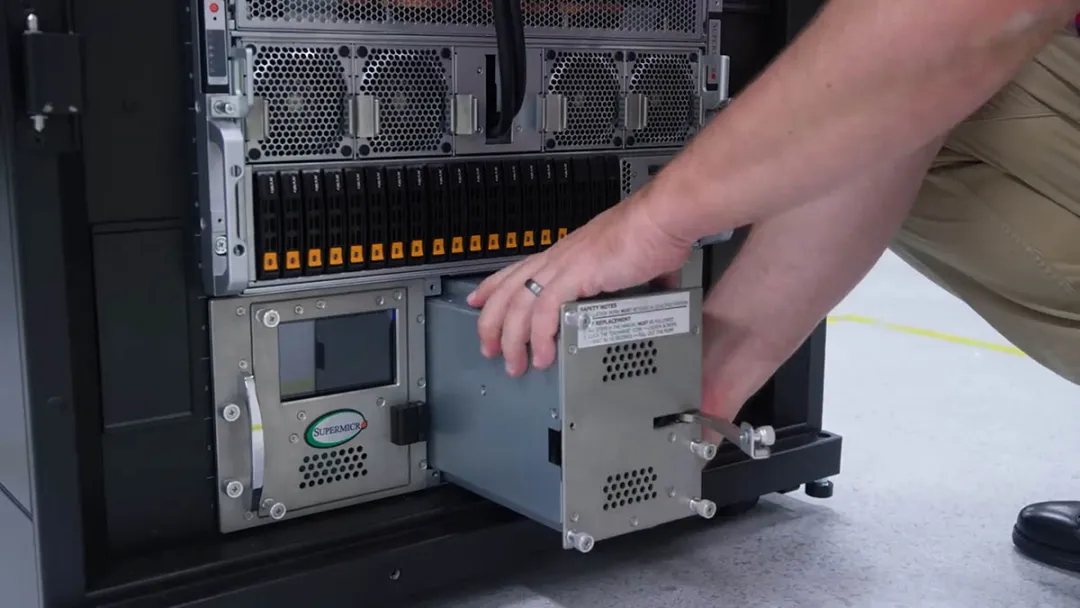

每个 CDU 配备冗余的泵和电源,以便在任何一个出现故障时,可以现场更换而不必关闭整个机架。由于我之前在类似设备上更换过泵,因此考虑在 Colossus 上进行更换,但我意识到这可能不是明智的选择,因为去年我们已经录制了我更换泵的过程。

Patrick 拆卸 Supermicro CDU 泵

xAI 机架里有很多设备,但在拍摄 2023 年的片段时,我们清晰地捕捉到了 Supermicro CDU。在这里,可以看到供水和供机架歧管的进出口,以及每个 CDU 的热插拔冗余电源。

Supermicro CDU 2023 后置 1

这是 Colossus 机架中的 CDU,被各种管子和电缆隐藏着。

XAI Colossus 数据中心 Supermicro CDU 后部

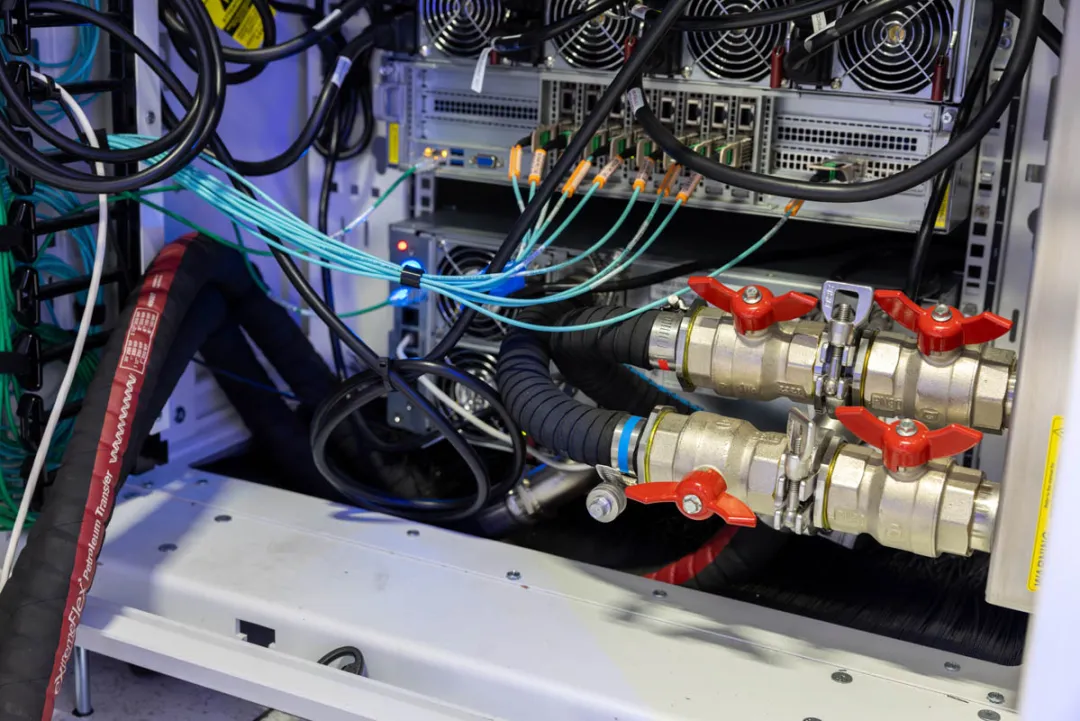

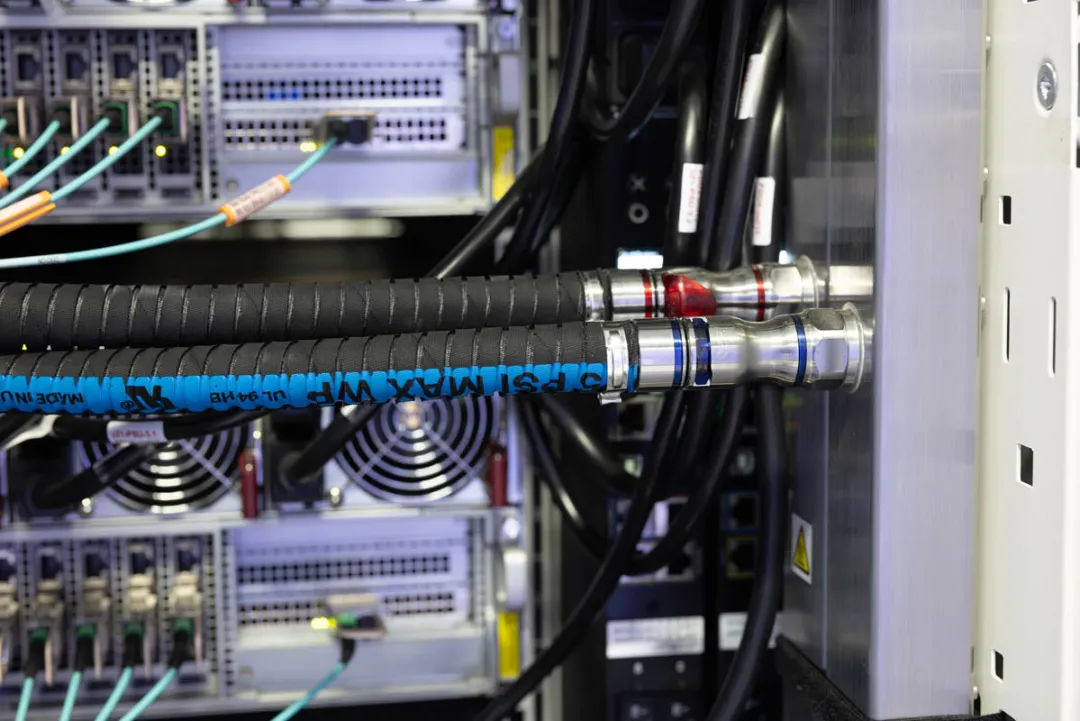

在 Colossus 机架的两侧,安装了三相 PDU 和机架歧管。每个前置的 1U 歧管为 4U 通用 GPU 系统供水,并由连接到 CDU 的机架歧管供水。所有组件都用红色和蓝色的接头标记,这种颜色编码方案非常直观,红色表示温暖,蓝色则表示冷却流体。

XAI Colossus 数据中心 Supermicro 机架歧管软管

您可能注意到这些照片中依然有风扇。风扇在许多液冷服务器中用于冷却 DIMM、电源、低功耗主板管理控制器和网络接口卡等组件。在 Colossus,每个机架需要保持与数据大厅的冷却中性,以避免安装大型空气处理器。服务器的风扇从机架前部吸入冷空气,后部排出废气,空气随后通过后门热交换器排出。

XAI 数据中心参观后门热交换器

后门热交换器的工作原理类似于汽车散热器。它们将机架内的废气通过热交换器,热交换器中流动的液体可以将热量传递到设施的供水回路。空气由位于设备后部的风扇吸入。与常见的汽车散热器不同,这些设备还具有一个很酷的功能。在正常工作时,它们会发出蓝光;如果出现问题,则会变为红色。当我参观施工现场时,尽管没有开启一些机架,但看到热交换器根据机架的状态变化颜色,确实很有趣。

XAI 数据中心参观后门热交换器

这些后门热交换器在数据大厅中还起到另一个重要作用。它们不仅能有效去除 Supermicro 液冷 GPU 服务器产生的多余热量,还能从存储、CPU 计算集群和网络组件中移除热量。

xAI基于超微的存储

存储系统非常引人关注。在人工智能集群中,通常会有大型存储阵列。在这里,我们看到不同厂商的存储软件在运行,但几乎所有的存储服务器都是超微的,这并不令人意外,因为超微是许多存储厂商的OEM。

XAI Colossus 数据中心 Supermicro 1U NVMe 存储节点

在参观过程中,一个有趣的发现是一些存储服务器与CPU计算服务器非常相似。

我们拍摄的照片和视频中,你会看到很多 2.5 英寸 NVMe 存储位。我们在 Substack 上提到,大型人工智能集群正逐渐从基于磁盘的存储转向闪存,这样可以显著节省电力,同时提升性能和密度。虽然闪存的每PB成本可能更高,但在这种规模的集群中,从总体拥有成本(TCO)来看,闪存通常更具优势。

xAI基于超微的 CPU 计算

在所有这些集群中,传统的 CPU 计算节点数量也相当可观。处理和数据操作任务在 CPU 上的表现通常比在 GPU 上更佳。你可能还希望将 GPU 用于人工智能训练或推理工作负载,而不是其他任务。

XAI Colossus 数据中心 CPU 计算机架

在这里,我们看到的是 1U 服务器的机架。每台服务器的设计旨在平衡计算密度与产生的热量。一个好的例子是,前面的 NVMe 存储位有橙色标签,面板大约三分之一的部分用于吸入冷空气。

XAI Colossus 数据中心 CPU 计算机架 2

这些 1U 计算服务器可以通过风扇降温,同时后门热交换器可以去除热量并与设施水路进行热交换。由于数据中心设计采用了后门热交换器,xAI 能够处理液冷设备和风冷设备。

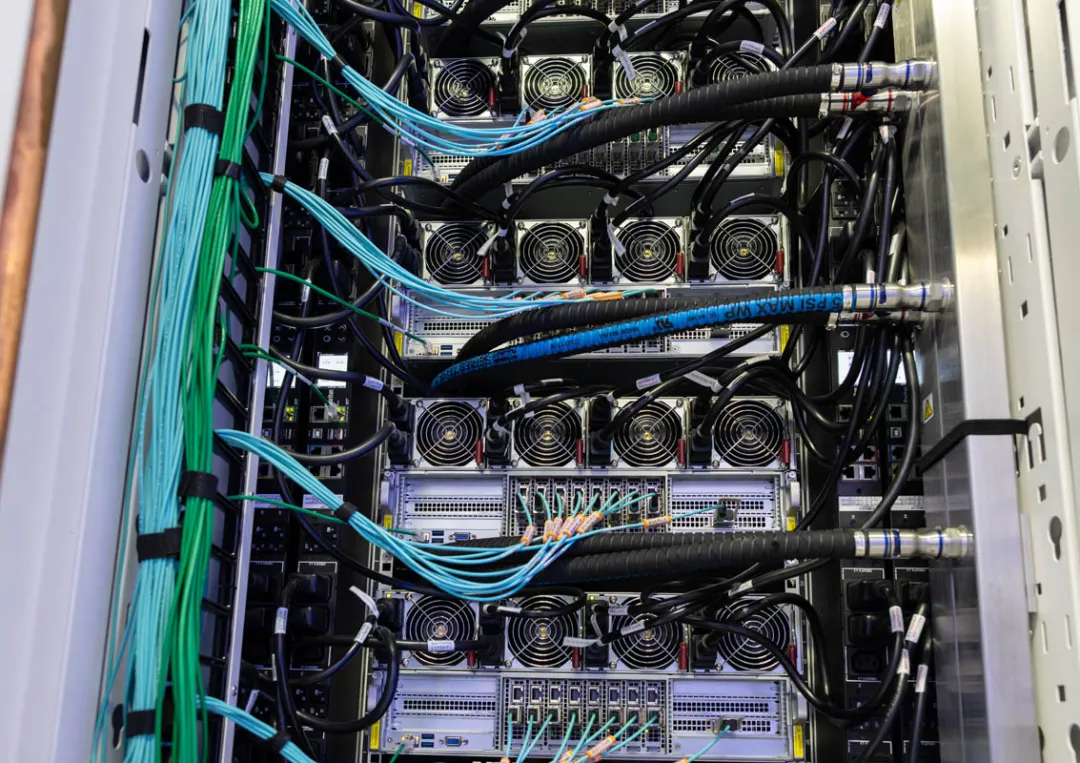

xAI Colossus 的网络

网络是一个非常有趣的部分。如果你的计算机使用以太网电缆,那么这里的基础技术是相同的。不过,这里采用的是 400GbE,速度是普通 1GbE 网络的 400 倍。每个系统还有九条这样的连接,这意味着每个 GPU 计算服务器大约有 3.6Tbps 的带宽。

XAI Colossus 数据中心 NIC(网络接口)

GPU 的 RDMA 网络占据了大部分带宽。每个 GPU 都配有自己的网卡。这里,xAI 使用 NVIDIA BlueField-3 SuperNIC 和 Spectrum-X 网络。NVIDIA 的网络架构帮助确保数据能顺利到达目标,避免集群中的瓶颈。

XAI Colossus 数据中心交换机光纤 1

这很重要。许多超级计算机网络使用 InfiniBand 或其他技术,但这里用的是以太网。以太网意味着扩展性很强。所有在 STH 上阅读的人最终都会通过以太网网络访问页面。以太网是互联网的基础,因此是一个极具扩展性的技术。这些庞大的人工智能集群正在向一些尚未触及的规模扩展,这是 xAI 团队的一项大胆尝试。

除了 GPU 的 RDMA 网络,CPU 也有一个 400GbE 连接,采用完全不同的交换结构。xAI 为其 GPU 和集群的其他部分分别运行一个网络,这是高性能计算集群中常见的设计。

XAI Colossus 数据中心单模和多模光纤

为了让你感受到 400GbE 的速度,它的连接能力超过了 2021 年早期顶级的英特尔 Xeon 服务器处理器在所有 PCIe 通道上的总和。在这里,每台服务器的网络连接达到了九倍的使用量。

XAI Colossus数据中心交换机堆栈

所有这些网络意味着我们有大量的光纤布线。每条光纤线路都经过切割到适当长度,并做好标记。

XAI Colossus数据中心的光纤线路

八月份我有幸见到了一些从事这项工作的人。看到结构化布线总是让人感到井井有条。

XAI Colossus数据中心架空电缆

除了高速集群网络,还有用于各种管理接口和环境设备的低速网络,这些设备是任何此类集群的一部分。

在参观这家设施时,很明显急需液冷网络交换机。我们最近评测了一款 64 端口的 800GbE 交换机,与许多 AI 集群中使用的设备处于同一 51.2T 类别。行业亟需解决的不仅是冷却交换芯片,还包括现代交换机中光学部分的冷却,这些部分通常消耗的电力超过交换芯片。或许,像这样的大型部署将推动行业向共封装光学器件发展,从而使交换机的冷却能够与计算设备同步采用液冷技术。我们之前已经见证了液冷共封装光学交换机的演示,因此期待这次对该安装的考察能够助力这些技术从原型阶段过渡到未来的量产。

Colossus 基础设施

由于我们配备了液冷系统的 AI 服务器机架,电力和设施用水对安装至关重要。这里展示了巨大的水管,分为冷水和热水两组。冷水进入设施后,循环通过每个机架的冷却分配单元(CDU),而热量则从 GPU 和后门热交换器的回路转移到设施水回路中。热水随后被送到设施外的制冷机,目标是降低水温,使其适合再次循环使用,而非制造冰块。

XAI Colossus数据中心的水管设施

电力方面非常有趣。在孟菲斯系统构建期间,我们目睹了团队在布置巨大的电缆。

XAI 科洛塞斯数据中心:与帕特里克共同展示部分电气基础设施,规模展示

在设施外,我们看到了一些装有特斯拉 Megapack 的集装箱。这是团队在建设这个庞大集群时的一个重要发现:AI 服务器并不会全天候以 100% 的功率运行,而是存在许多功耗的峰值和谷底。随着工作负载转移到 GPU,功耗会波动,因此团队在中间添加特斯拉 Megapack 来缓冲这些波动,从而提高整体系统的可靠性。

特斯拉 Megapacks 已准备好在 XAI Colossus处安装

设施的建设才刚刚开始。我们访问时,初始的四个 25,000 GPU 数据中心已经运行,支撑着约 100,000 个 GPU,而集群的扩展工作也在快速进行。

美国孟菲斯 XAI 科洛塞斯数据中心室外扩建

这似乎预示着一个令人激动的新起点。

暂无评论内容