LSTM+Transformer,最新成果登Nature,在多任务实时预测中,即使数据保留率为50%,模型性能依然最优。

事实上,LSTM与Transformer的结合,一直是深度学习的热门,也是改进模型性能的利器!不仅可以更好地处理时间序列数据,还可以减少整个模型的计算量,提高训练速度。

LSTM能有效地捕捉长期依赖关系,并避免梯度消失或爆炸问题。但其在处理时间序列时需要进行顺序计算,无法并行化,这限制了其计算效率。Transformer则具有高效的并行计算能力!两者结合使用,能够优势互补!

为让大家能够更好地改模型、涨点,我给大家准备了11种融合思路,原文和代码都有!一起来看看吧!

精彩论文

- SwinLSTM: Improving Spatiotemporal Prediction Accuracy using Swin Transformer and LSTM

「论文简述」

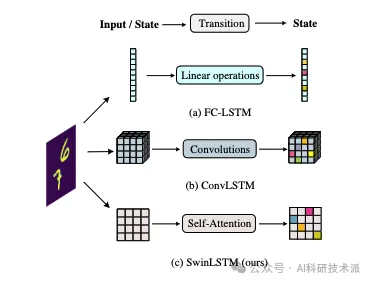

集成CNN和RNN来捕获时空依赖关系是时空预测任务的常用策略。然而,CNN学习局部空间信息的特性降低了其捕获时空依赖关系的效率,从而限制了其预测精度。

在本文中,作者提出了一个新的循环单元,SwinLSTM,它集成了Swin Transformer模块和简化的LSTM,这是一种扩展,用自关注机制取代了ConvLSTM中的卷积结构。在此基础上,构建了以SwinLSTM单元为核心的时空预测网络。没有使用独特的技巧,SwinLSTM在Moving MNIST, Human3.6m, TaxiBJ和KTH数据集上优于最先进的方法。特别是,与ConvLSTM相比,它在预测精度上有了显著的提高。

- 「Nature」 Advanced hybrid LSTM-transformer architecture for real-time multi-task prediction in engineering systems

「论文简述」

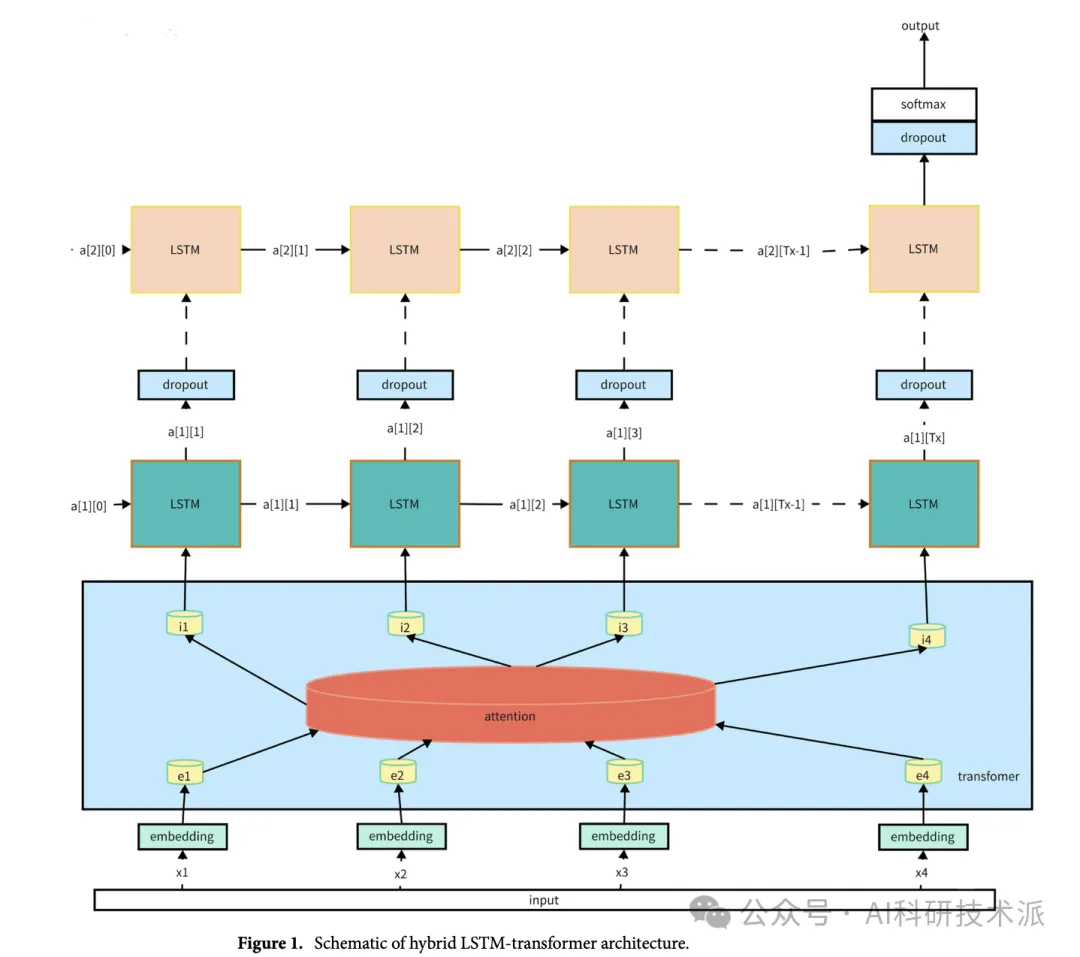

在工程系统领域,特别是在地下钻探和绿色雨水领域管理——实时预测对于提高运营性能、确保安全、提高效率。为了解决这个问题,本文提出了一种新的LSTM-transformer混合模型架构,专门用于多任务实时预测。以进步为基础在注意力机制和序列建模方面,该模型融合了LSTM的核心优势Transformer架构,为传统预测模型提供了更好的替代方案。

随着在线学习的进一步丰富,该架构可动态适应可变操作条件和不断合并新的油田数据。利用知识蒸馏技术,有效地从更大的预训练网络中迁移见解,从而实现高预测不牺牲计算资源的准确性。严格的行业实验工程数据集验证了所提方法的鲁棒性和有效性。值得注意的是,我们的与现有方法相比,该模型在预测精度、实时性等方面具有明显优势适应性和计算效率。这项工作提供了一个开创性的预测框架针对有针对性的工程应用,提供可行的见解。

- Learning-based NLOS Detection and Uncertainty Prediction of GNSS Observations with Transformer-Enhanced LSTM Network

「论文简述」

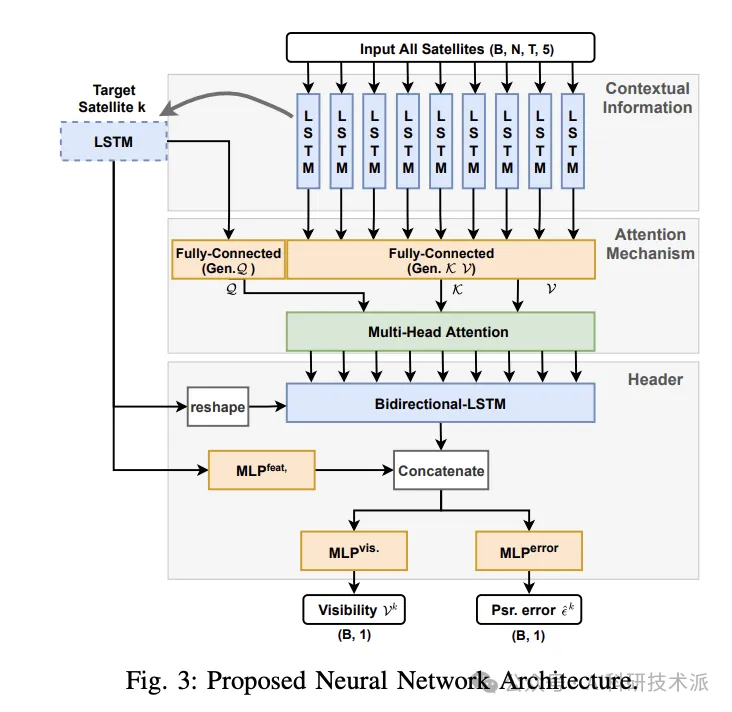

这项工作提出了一种基于深度学习的方法,通过分析GNSS观测作为一个时空建模问题来检测NLOS接收并预测GNSS伪距误差。与以往的工作相比,作者构建了一个类似Transformer的注意力机制来增强长短期记忆(LSTM)网络,提高模型的性能和泛化。对于所提出的网络的训练和评估,作者使用了来自香港和亚琛的标记数据集。作者还介绍了使用激光雷达地图标记GNSS观测数据的数据集生成过程。在实验研究中,作者及其团队将所提出的网络与基于深度学习的模型和经典机器学习模型进行了比较。此外,作者对网络组件进行了消融研究,并将NLOS检测与状态估计器中的数据分布外集成在一起。

- Transformer Language Models with LSTM-Based Cross-Utterance Information Representation

「论文简述」

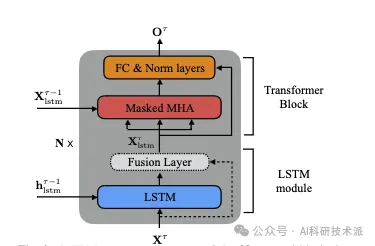

交叉话语信息的有效整合有可能改善自动语音识别(ASR)的语言模型。为使(Transformer LM)提取更强大和鲁棒的交叉话语表示,本文提出了在长短期记忆(LSTM) LM中使用隐藏状态的R-TLM。为了对交叉话语信息进行编码,R-TLM在一些Transformer块中结合了LSTM模块和分段递归。除了LSTM模块输出外,还研究了使用融合层绕过LSTM模块的快捷连接。

在AMI会议语料库、Eval2000和RT03电话会话评价数据集上对该系统进行了评估。在AMI评估集Eval2000和RT03上,最佳R-TLM比单话语TLM基线的绝对WER分别降低了0.9%、0.6%和0.8%,比强交叉话语TLM基线的绝对WER分别降低了0.5%、0.3%和0.2%。显著性检验进一步支持了对Eval2000和RT03的改进。r – tlm被发现在更容易发生识别错误的单词上有更好的LM分数。通过LSTM-LM插值可以进一步减小R-TLM的WER。

- Incorporating Transformer and LSTM to Kalman Filter with EM algorithm for state estimation

「论文简述」

卡尔曼滤波要求模型参数真实,递归求解最优状态估计。期望最大化(EM)算法适用于卡尔曼滤波前无法得到的模型参数的估计,即EM-KF算法。为了提高EM-KF算法的精度,在序列到序列(seq2seq)的编码器-解码器框架下,提出了一种将长短期记忆网络(LSTM)、Transformer和EM-KF算法相结合的状态估计方法。对一个线性移动机器人模型的仿真表明,该方法具有较高的精度。

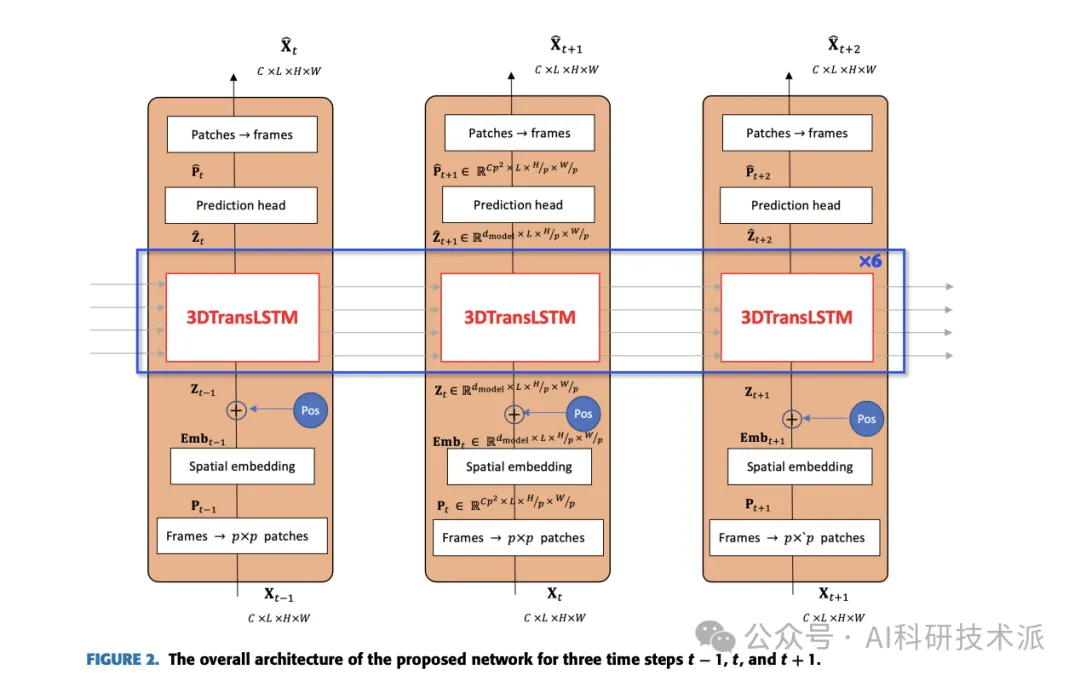

- A Hybrid Transformer-LSTM Model With 3D Separable Convolution for Video Prediction

「论文简述」

本文提出一种新的视频预测网络3DTransLSTM,采用混合网络Transformer-长短期记忆(LSTM)结构继承了自注意力和自注意力的优点递归。在这种混合结构中使用三维(3D)深度可分离卷积来提取时空特征,同时提高模型效率。作者进行了实验研究在四个流行的视频预测数据集上。与现有方法相比,提出的3DTransLSTM通过显著减少模型大小、可训练参数,实现了具有竞争力的帧预测精度,以及计算复杂性。

- A BiLSTM–Transformer and 2D CNN Architecture for Emotion Recognition from Speech

「论文简述」

情感识别技术的意义正在不断地增长和研究在这一领域使人工智能能够准确地理解和反应人类的情感。该研究旨在利用语音情感特征来提高语音情感识别的效果可视化的归约算法,有效地概述特定情感的音频特征。作为一个对于情感识别,作者提出了一种新的模型架构,融合了双向情感识别长短期记忆网络(BiLSTM) -Transformer和二维卷积神经网络(CNN)。

BiLSTM-Transformer处理音频特征以捕获语音模式序列,同时2D CNN处理梅尔频谱图以捕获音频的空间细节。为了验证针对模型的熟练程度,采用了10折交叉验证方法。所提出的方法将语音情感识别方法应用于Emo-DB和RAVDESS两种主要的语音情感识别在多个数据库上进行实验,分别取得了95.65%和80.19%的高未加权准确率。这些实验结果表明,所提出的基于transformer的深度学习模型具有合适的使用价值。在语音情感识别中,特征选择可以提高识别性能。

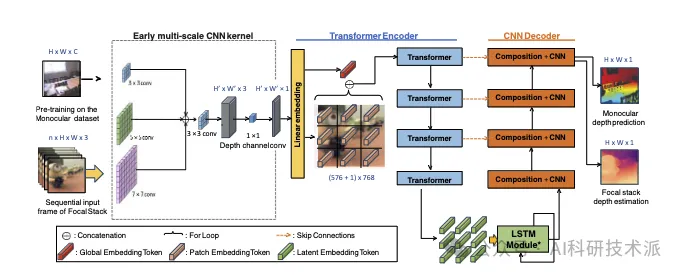

- FocDepthFormer: Transformer with LSTM for Depth Estimation from Focus

「论文简述」

本文开发了一种新的基于Transformer的网络,FocDepthFormer,主要由带LSTM模块的Transformer和CNN解码器组成。Transformer中的自关注功能可以通过隐式的非本地交叉引用来学习更多信息丰富的特性。学习LSTM模块来集成跨堆栈的表示与任意图像。为了直接捕获不同程度聚焦/散焦的底层特征,作者建议在早期编码器中使用多尺度卷积核。得益于LSTM的设计,FocDepthFormer可以用丰富的单目RGB深度估计数据进行预训练,用于视觉模式捕获,减轻了对难以收集的焦点堆栈数据的需求。

暂无评论内容